訪談硅谷與中國近 100 位與大模型相關的創業者、投資人、大廠決策層后,5 個你需要了解的大模型世界觀。

文 |凌晨 段宛辰 黎詩韻 李源 衛詩婕

編輯 |衛詩婕

回看歷史總是充滿戲劇性。

2021 年 5 月,谷歌 I/O 大會,一段由聊天機器人 LaMDA 扮演「冥王星」與人類對話的 Demo 被演示出來,當即博得現場的掌聲。此時距離谷歌定下「AI First」的目標已經過去六年,距離 OpenAI 震驚世界的 ChatGPT 發布還有將近 18 個月。

這個時候,谷歌仍是 AI 領域的先行者。但項目背后的兩位關鍵工程師,De Freitas 和 Shazeer 卻感到沮喪。

他們希望能夠對外展示 LaMDA 進入 Google 助手的案例,但多年來,聊天機器人項目經過多次審查,由于種種原因被禁止發布更廣泛的版本。

而此前一年,OpenAI 已經公布了 1750 億參數的 GPT3,并開放了 API 測試。谷歌卻因為各種「技術政治正確性」的風險,遲遲不愿將對話模型的產品對外公開。

De Freitas 、Shazeer 因此萌生去意,盡管 CEO Pichai 親自進行挽留,但最終,兩人還是在 2021 年底離開谷歌,創辦了 Character AI——目前 AI 大模型領域的獨角獸之一。

谷歌就這樣與引領變革的先發優勢失之交臂。

后來的故事更加廣為流傳。2022 年底,ChatGPT 橫空出世,這不僅使 OpenAI 名聲大噪,更令其投資方微軟大殺四方,在 GPT-4 的加持下,微軟推出搜索產品 New Bing,劍指谷歌。不僅谷歌,整個硅谷乃至世界也都為之震動。

轉眼 8 個月過去,大洋彼岸,OpenAI 帶來的驚異已過,硅谷巨頭們已度過恐慌期,也在全新戰局中找到身位,創業公司前赴后繼,在中國,百模大戰則又是另外一番景象。

技術商業快速變化的半年來,業界關于大模型的認知與共識也不斷更新,極客公園在與硅谷和中國近百位創業者、投資人、從業者交流后,總結出關于大模型創業的 5 個現狀,嘗試以此呈現一篇尚待驗證的「大模型商業世界觀」。

谷歌的機遇錯失與 OpenAI 的驚艷亮相實則提醒著我們——落后,先機,時有交替。當下的技術與商業演進遠未到終局,真正的變革甚至還未正式開始。人們只需記住,創新可能隨時、隨地發生。

注:全文共 14573 字,閱讀預計需 30 分鐘左右。建議關注、收藏后觀看。

薛定諤的 OpenAI :所有人的英雄,也可能是所有人的敵人

當中國創業圈還在將 OpenAI 視為硅谷新神時,硅谷已經悄悄開始了對 OpenAI 的祛魅。

盡管 OpenAI 實現了技術的突破、并且仍然是 AI 人才們趨之若鶩的地方——很多企業號稱要向 OpenAI 狙擊人才——而事實是,時至今日,OpenAI 的頂級技術人才依舊在「凈流入」。其對 AGI 的信念和過去 8 年由愿景驅動帶來的技術突破,使這家公司成為很多人眼里的英雄。

但英雄也要過日子。技術突破的下一步,是創造價值來創造商業循環。硅谷的爭議在于,OpenAI 真的能持續領先嗎?

多位硅谷創業者、從業者、投資人不約而同地向極客公園表達了消極的判斷。人們質疑的是,就目前看來, OpenAI 所呈現的商業模式存在隱憂——在「前 ChatGPT」的非共識階段,OpenAI 尚可以憑借少數人的信念贏得資源,而今 AGI 已成共識,競爭者眾,想要維持領先,挑戰與難度將直線上升。

如果把商業盈利模式統分為 toB 和 toC,前者 OpenAI 沒有 toB 基因,且勁敵當前——在企服方面,OpenAI 的資方微軟是這個領域的王者,微軟系的企業聊天應用市占率超 65%,旗下的 Teams 近年逐漸蠶食了明星公司 Slack 的市場。在 toB 領域,成立 48 年、跨越數次技術周期的微軟毫無疑問比初創公司 OpenAI 積累更深。

而要想做 toB 生意,OpenAI 還面臨著中心化風險的質疑。目前,OpenAI 面向企業所開放的 API 模式,已經吸引了一批客戶使用它——尤其是中小開發者,它們無力獨立訓練一個大模型,接入 GPT 系列的 API 成為極佳的選擇。剛剛躋身獨角獸的 Jasper.AI 就是其中最好的例子,通過接入 GPT3,Jsaper.AI 僅成立 18 個月就估值 15 億美金。

「但大家因此都不看好 Jasper.AI。」一位硅谷主流基金的投資人告訴極客公園。私有數據是企業最重要的資產,在目前,將私有數據接入中心化大模型首先面臨著合規與安全性的問題——盡管 Sam Altman 在 5 月曾經承諾,OpenAI 不會利用客戶使用 API 的數據進行訓練——但這既無法打消企業的疑慮,也無法獲得其信任。

「美國一些企業客戶普遍對用 OpenAI 比較擔憂。」這位投資人告訴我們,在企業眼中,OpenAI 最接近云時代的 AWS,但是大家又不會用面對 AWS 的邏輯面對它。「客戶普遍不太愿意把數據和關鍵競爭力交給 OpenAI,覺得會有風險」。即便 GPT 系列能夠以中心化的能力幫助垂類領域訓出大模型,對客戶來說,憑此構建的競爭力也很危險——這將是一種「吸星大法」:如果自己的數據和經驗最終也能為別人所調用,這將使行業領先者的競爭壁壘下降。

而做 toC 呢?

看起來,OpenAI 在 C 端擁有用戶優勢。自其超級產品 ChatGPT 發布以來,其月活一路攀升至 15 億,相比之下,Instagram 的月活也不過 20 億。不過,巨大的月活卻未必能為 OpenAI 帶來數據飛輪效應——「(通過)用戶持續問問題來做(大模型的)training,數據價值不大。」一位創業者指出。

值得注意的是,自 6 月開始,ChatGPT 的月活首次出現下滑。人們對此的推測包括:

-

因為對科技的新鮮感已經下降——實際上 ChatGPT 的訪問量增長一直在下滑,5 月環比僅有 2.8%。

-

學生放假導致學生使用量降低;

- 以及一個更為嚴重的猜測,ChatGPT 的回答質量下降導致使用量下降——GPT-4 剛剛推出的時候,速度較慢而回答質量較高,而幾周前的一次更新,有用戶反饋其回答速度增強,但質量有了可感的下降。

更重要的是,包括 Google 、Meta、蘋果等在內的巨頭也將圍繞 toC 產品進行發力。比如 Google 已經重新整合了 Brain 和 Deepmind 兩個內部團隊以求在技術上壓制 OpenAI 的優勢。「以前者的超大用戶規模,一旦巨頭推出免費產品,則可能沖擊 OpenAI 現有的訂閱收入。」OpenAI 需始終維持住其技術壁壘,一旦技術壁壘被打破,則可能輕易被巨頭以價格優勢發起攻擊。

今天的 OpenAI,就像薛定諤的貓,難以斷言它的前路是否明朗,可以確定的是,它將會在所有巨頭密切監視的范圍之內。

最頂級的公司各選山頭,但目標上殊途同歸

那么,硅谷的巨頭們在做什么?

極客公園與大量硅谷從業者交流后發現,與 ChatGPT 初亮相時相比,硅谷巨頭公司的恐慌期已經基本結束。這些商場老將們迅速確立了自己的山頭,并加速技術的推演,以防守好自己擅長的象限,確保自己不會被顛覆。

他們一致的做法是,沿著自身已有的優勢進行擴展布局,尋找大模型能為之助力、甚至可能發生顛覆式創新的方向,一方面加固自己的業務優勢,防范對手的突然襲擊;另一方面也為可能出現的新戰場埋下先手。

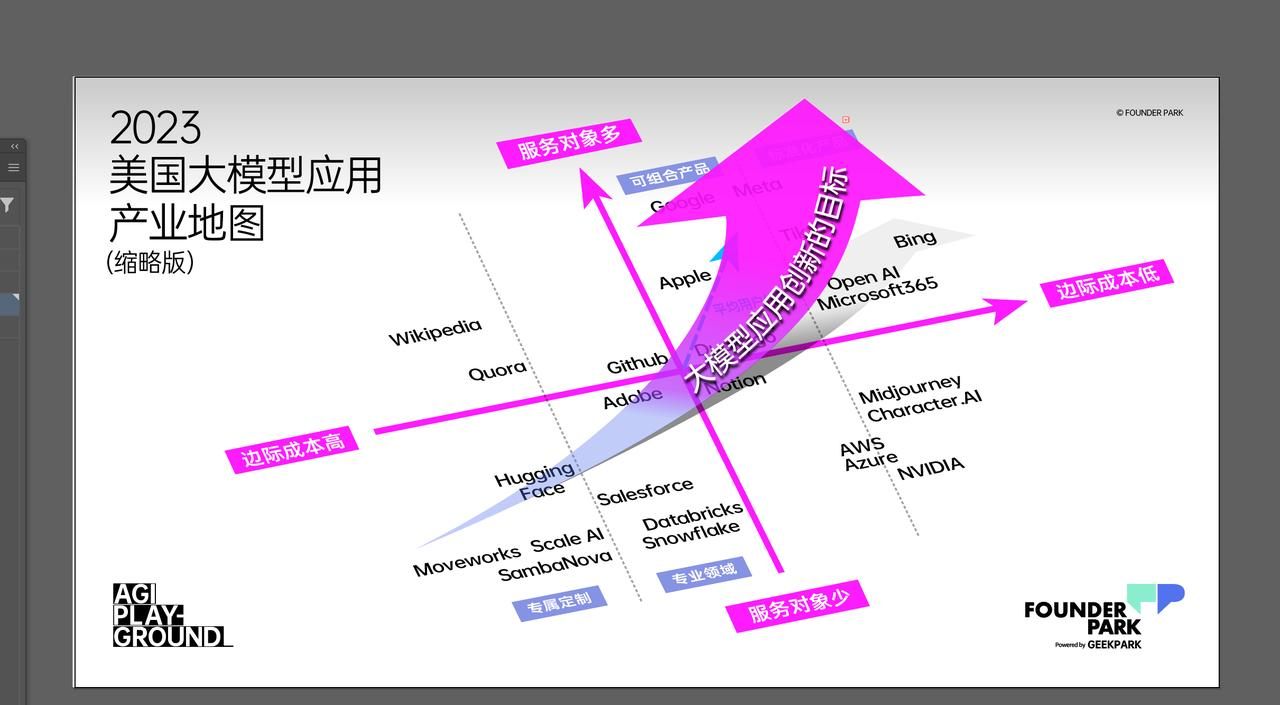

極客公園創始人兼 CEO 張鵬在不久前引發眾多關注的 AGI Playground 大會演講中,曾經講解了這樣一個觀察。

從一個公司的價值評估角度來看,如果以服務方式帶來的邊際成本高低為橫軸(X 軸),以服務對象多少為縱軸(Y 軸)、并以平均客戶價值(客單價、ARPU值等的高低)為空間軸(Z 軸)來建立一個價值坐標系,則會發現,硅谷巨頭們各有各的山頭要守衛,但又有統一的發展趨勢逐漸確立。

邊際成本低,服務對象多、而平均客戶價值高,這三個核心能力占據兩點以上,往往才能自占據商業世界的最高價值。

目前,傳統巨頭在大模型領域的技術投入普遍都是在積極防御,只有微軟和英偉達在非常積極地推動向應用中的落地。

而目前硅谷影響力最大的新生代企業,如 OpenAI、Midjounery、Character.AI 等公司,則是明顯利用了大模型技術能力,迅速打破「低邊際成本、大用戶量、高度個性化服務價值」的不可能三角——顯然,這也是 AGI 技術變革的意義:用更低的邊際成本服務更多客戶,并交付更個性化的價值,進而獲得更高的平均用戶價值。

「目前,所有的巨頭都會努力跟上這波變革,也努力守住自己在價值地圖中的位置。而新興的企業努力的目標,則是無論你從哪個象限的位置出發,都盡可能地去追求用 AGI 技術向你所在的象限,甚至是突破原有象限的向右上移動,并盡力追求更高的平均客戶價值。」張鵬在演講中說。

在這樣的大趨勢下,我們不妨看看硅谷巨頭們目前的狀態和決策:

- 蘋果:不靠譜就不冒險,堅持 toC 固基業

作為曾被寄望能實現電影《Her》中場景的蘋果,盡管今天仍未能實現如此深刻的人機交互,但這家向來秉承長期主義的公司不會放棄——相比于通用大模型,蘋果的策略選擇基于自身的基業,堅定在 to C & 標準化的方向。

蘋果希望 AI 模型最終能在終端硬件上運行——這需要讓模型能夠在算力較弱的環境下運行,目前還無法達到。它對 AI 的運用也更為務實:今年轟動一時的 Vision Pro 中,蘋果利用 AI 技術,使佩戴者在 FaceTime 視頻時能夠有全方位的虛擬化身。在 WWDC 上,蘋果還展示出了 autocorrect 功能,通過讓一個 Transformer 架構下的大語言模型在手機上運行,以修改用戶的錯字、并更好地預測用戶的語言習慣。

如果說 Vision Pro 是蘋果押注的下一代數字終端,新終端帶來新的數字內容需求,在終端上運行大模型則是實現終端內容的技術前提。

在用大模型研發 to C 產品上,蘋果尚未制定明確的戰略。這也顯示了蘋果在終端產品上的謹慎。

已經有消息表示,蘋果在開發新一代人工智能技術:蘋果去年搭建了機器學習開發的 Ajax 框架,并基于其構建了類聊天機器人 AppleGPT。但是這一技術目前只被要求服務于內部員工,比如給 AppleCare 工作人員提供支持,以更好地幫助客戶處理問題。

蒂姆 · 庫克在 5 月份的財報電話會議上談到當前的人工智能技術時表示,還有許多問題需要解決。正如蘋果給到了 Vision Pro 充足的耐心,對于 AI 大模型如何進入產品,目前看起來也同樣充滿耐心。

- Meta:以 Llama 打造下一代「安卓」,損人且利己

社交網絡出身的 Meta 仍然在朝著它打出的概念——元宇宙進發。

如果將大模型視作為下一代計算平臺,Meta 正以開源的方式挑戰 OpenAI,目的是要成為應用生長的土壤。開放 Llama2 商業許可,并與微軟 Azure 合作對外提供服務、與高通合作推進在終端運行 Llama2,這一系列動作讓 Meta 的戰略布局更加明顯。通過云服務,模型服務能夠向 B 端方案滲透,通過與高通合作,又能夠促進基于終端的應用開發。

而在新技術提升已有業務效果上,Meta 也動作迅速。6 月,扎克伯克宣布了全平臺產品整合生成式 AI 技術。此前,幫助廣告商生成文案、測試廣告效果的 AI 生成服務 AI Sandbox 已經上線,這將直接服務于 Meta 營收核心的廣告業務。

看起來,Meta 走在提供標準化模型能力的路徑上,試圖在 toB 和 toC 領域兩頭開花。從其目前困境來看,不難理解背后原因——Meta 已有的超級應用 Facebook 并不能構成真正的護城河,從元宇宙開始,Meta 已經在思考布局下一代計算平臺 VR 頭顯,但是創造一代全新計算平臺及生態的挑戰巨大,并且進度上低于預期。

大模型給了 Meta 新的希望。比如在技術上 Text to Image(文轉圖)發展很快,來自硅谷的大廠技術專家們普遍認為 Text to 3D(文轉 3D)的能力會很快速地增長——這有助于 Meta 的元宇宙生態。

因此,Meta 通過 Llama 來提供開源的能力,既可以擊碎其他巨頭的技術獨占價值,也能促進大模型技術更快地被運用到自己的現有業務和元宇宙生態,是一石三鳥的好機會。

- 亞馬遜:持續領跑云服務,CEO 親自掛帥「最具野心的 AI 項目」

亞馬遜是另一個一度被外界質疑落后于 AI 變革的巨頭,但最新消息顯示,它正在奮起直追。

2 月,亞馬遜推出了自家的開源大模型 mm-cot,盡管在模型架構上,創新地提出了包含視覺特征的思維鏈,但在層出不窮的開源模型社區,并沒有引起太大水花。而截至發稿前,據外媒 Insider 最新報道稱,亞馬遜 CEO Andy Jassy 目前正親自帶隊,該團隊負責開發該公司最具野心的 AI 項目。

作為云服務的領跑者,占有 48.9% 市場份額的亞馬遜在 B 端有著絕對的客戶優勢。因此,圍繞 B 端,自 4 月以來,亞馬遜推出了大模型服務 Amazon Bedrock,其中既包括自研的大模型,也與 AI21 Labs、Anthropic、Stability AI 等基礎模型提供商廣泛合作,助力企業輕松靈活構建生成式 AI 應用,降低所有開發者的使用門檻。

此外,為了抑制和解決 AI「一本正經地胡說八道」,亞馬遜還打造了 Amazon Titan 基礎大模型,它可以識別和刪除客戶提交給定制模型的數據中的有害內容,過濾模型中不當內容的輸出結果。

同時,亞馬遜業務的根本——提供算力,仍然是大模型時代的「剛需」。

即使在大模型時代技術棧會發生變化,云服務依舊是計算的底層支撐,AWS 需要更好地嵌入新的技術棧。而新繁榮的模型工具層,諸如 DataBricks、BentoML 等都會選擇和云平臺合作,分享收益。

4 月,亞馬遜網絡服務(AWS)宣布與 Stability AI 和 Hugging Face 等人工智能公司建立合作伙伴關系,這將允許其他公司使用亞馬遜的基礎設施來構建人工智能產品。此外,AWS 還投資 1 億美元建立 AWS 生成式 AI 創新中心(AWS Generative AI Innovation Center),該中心將把客戶與公司的人工智能和機器學習專家聯系起來。他們將幫助醫療保健、金融服務和制造業的一系列客戶使用新技術構建定制應用程序。

而在 AI 領域深耕 20 年的亞馬遜,目前看來其野心并不甘落于微軟和谷歌之后,也不甘心只坐守 B 端優勢與成果。在 B 端之外,亞馬遜似乎也在發力 C 端;同時,除了去中心化地提供模型能力賦能,亞馬遜也在打造中心化的大模型——這也是 Andy Jassy 親自掛帥的目的。

- 微軟:手握王牌,B 可攻、C 可守

作為 OpenAI 的投資方,借前者的技術能力與影響力,微軟在 B 端和 C 端都極早開始布局——在 B 端,微軟獲得了布局云平臺新技術棧的先機,同時將來自 OpenAI、Meta 的模型接入云服務,以期切走云市場更大的蛋糕。而在 C 端,微軟則開始打造前端產品、用大模型做 Copilot :如在自身的強勢產品 Office 365 中上線 AI 的新功能、將 OpenAI 的大模型接入 Bing 搜索中,發布 New Bing 產品,成為第一批大模型成熟產品的典型。

B 端與 C 端的雙線推進,不僅鞏固了微軟原有的 toB 優勢,同時也加固自己的壁壘以防他人顛覆。

此外,在更底層的硬件層面,微軟也對 AWS 等云服務廠商發起了攻擊。在更底層的硬件層面,微軟也從 2019 年在內部開始研發代號為「雅典娜」的 AI 芯片,這些芯片正式為訓練大語言模型等軟件而設計,同時可支持推理,為基于大模型的軟件提供算力。初代產品基于 5 納米工藝,微軟也已規劃了未來幾代芯片產品。

據了解,微軟依舊在擴大數據中心、采買芯片,能夠看出,為了延伸目前自身的優勢,微軟做了充分的技術布局,但挑戰在于,接下來能否在市場化上得到驗證。

最新截止 6 月 30 日的第四季度財報顯示,截至 6 月底,Azure OpenAI 擁有 1.1 萬用戶,和 5 月末的 0.45 萬相比出現大幅增長。智能云業務營收盡管在上漲,但較上一季度增速在放緩。此外,微軟在 7 月中旬,將 Microsoft 365 Copilot 的價格設定為每月每戶 30 美元,這被視為增加收入的方式。

目前看來,微軟不僅牢牢守住了自身的產品壁壘,也為自己開拓了全新的賽道和利潤來源。但能否守住大模型時代的先發優勢,有待進一步商業化驗證。

- 谷歌 :不能被低估的巨頭,奮起直追防閃擊

ChatGPT 橫空出世后,微軟立即與 ChatGPT 聯手推出 New Bing——因為擔心 GPT4 加持的 New Bing 將動搖谷歌搜索引擎的根基,Google 選擇在 2 月份倉促應戰——發布 Bard,給外界留下了大亂陣腳的印象,也影響到了人才的流出和資本市場的信心。

然而最新的二季度財報顯示的超預期增長,加之此前 I/O 大會上所展示的全面技術布局,又成功讓外界對其重拾信心。

這似乎也印證了,在已存在的市場,想利用范式革命顛覆當下的巨頭,沒那么容易。

早在 2015 年,Google 就定下了 AI First 的目標。但因內部原因,錯過了引領生成式 AI 的機會。Bard 之后,谷歌將背后的支持模型從輕量級的對話模型 LamDA 換成了 Google 自研的 PaLM 模型。今年 5 月,Google 發布了升級版的 PaLM2 模型,并一次性在包括 Gmail,Google Maps 等多個產品中添加了生成式 AI 帶來的新功能,在 C 端標準化產品方面十分積極。其中,最吸引外界關注的是兩項:PaLM2 能夠在端側運行的輕量級版本 Gecko,以及正在研發中的 Gemini 多模態模型。

當然,谷歌在 C 端擁有的強勢基因,這項優勢也被認為可能掣肘其在 B 端的探索——事實上,谷歌也將在 B 端發力:除了谷歌 TPU 外,新增基于英偉達 H100 的 A3 AI 超算,以及面向企業的 AI 平臺 vertex AI。

對谷歌而言,當下的局勢無疑是危險的。在大模型時代,搜索這個領域必將被許多對手涉足,身為搜索巨頭,谷歌隨時可能被狙擊,做好防守是它的死門。

極客公園了解到,經過年初的慌亂,巨頭已經平靜下來,開始了自己的動作。4 月,谷歌將 Deep Mind 與 Google Brain 合并重組為 Google DeepMind,由堅信 AGI 的 DeepMind 聯合創始人 Demis Hassabis 擔任部門領導,原 Google Brain 負責人 Jeff Dean 出任谷歌首席科學家——這樣的架構調整不僅可以進一步聚集資源,更可以窺見谷歌追趕的決心。

合并后的 Google DeepMind 以及 Google Research,目標是攻克多個人工智能關鍵項目,其中第一個即為多模態模型。有消息傳出,谷歌正在用 Youtube 的視頻數據訓練 Gemini。鑒于大模型的下一個關鍵技術將是多模態,這增加了谷歌是否會領先的猜測。

畢竟,谷歌擁有 30 億級用戶,在一年幾百億美金收入的前提下,也擁有強大的技術能力——這使得它即便反應不足夠快,但只要在技術上不落后,也能利用規模優勢守住自己的安全城池。

縱觀巨頭的商業布局,極客公園經廣泛交流后總結出幾個結論:

- 巨頭間的恐慌期已經結束,紛紛重新瞄準了自己的目標,核心是維持自己在產業的最高位,同時,如果有機會對競爭對手進行攻擊,自然也不會錯過。

- 在大模型這波范式革命前,理論上,任意一家成熟公司利用好大模型則可能具備對巨頭發起閃擊戰的能力,而任何一個巨頭如果不能快速行動,將大模型融入產品,則面臨著被降維偷襲的風險——如微軟搜索之于谷歌搜索,微軟云服務之于亞馬遜云服務。大模型帶來的可能性廣闊而未知,此前確立的商業邊界會重新模糊。

- 巨頭訓練自己的中心化大模型的目的,與 OpenAI 所常常談到的「達到 AGI」不同,其戰略意義更多出于防守。除了業務與 Chatbox(聊天機器人)強相關的 Google,各家未必強求訓練出一個世界頂尖的 ChatGPT 形態的產品,更在意的是使用大模型防守自己的業務,具備反閃擊戰的能力。

- 但由于技術尚在發展中,想利用大模型發起閃擊戰顛覆對手,或者用大模型本身規模化獲益,也遠沒有想象中容易:微軟自今年 2 月份推出 New Bing 后,曾一度被認為流量增長超過了谷歌,但 4 月以來,有報告顯示,必應的搜索份額不升反降,截止 7 月,谷歌搜索的地位并沒有被撼動的趨勢。而一位計劃用大模型服務 toB 領域的創業者告訴極客公園,巨頭想用大模型提供標準化服務,也一定程度會陷入激烈競爭:以他所在的 SaaS 公司為例,其后臺接入多個大模型(語言模型、翻譯模型等)——OpenAI、Google、開源模型等,「讓他們卷價格和性能去吧」,這位創業者這樣說道。

- 此外,大模型時代的硅谷,「Brain Drain(人才流失)is very real」。多個從業者告訴極客公園。無論從歷史還是當下,任何巨頭不能使用大模型構建出有競爭力的業務,頂級的 AI 工程師就會很快流失。早在 2022 年,因為 Meta 專注于元宇宙概念,曾被曝出多個資深 AI 專家跳槽,倫敦分部幾乎全部垮掉。OpenAI 早期更是從 Google 挖走了一百多人來擴展業務。而離開一家公司的頂級 AI 程序員,在短期內基本不可能回流。

- 最后,AGI 時代的云計算仍是絕對的巨頭賽場——云計算本身就是巨頭的生意,而訓練大模型需要巨大的算力。正如同淘金熱下,掙錢的將是賣鏟子的人——大模型底層和應用均有較高不確定的當下,云廠商一定會從中獲得利潤,在當下,如何提供「更優質的云服務」,比如用更低的算力優化計算結果、滿足模型訓練的需求與場景,將是巨大的優勢。

中間層的繁榮,才能把應用「抬進」大模型時代

對于創業公司而言,一名硅谷創業者告訴我們,「美國現在是中間層在繁榮,已經幾乎沒有新的創業者要做下一個OpenAI了。」

所謂中間層,是指要將大模型融合到應用,中間所需的一系列工程能力、AI 能力,由此需求出發,涌現出的一批「工具棧」——如開發工具鏈(如 Langchain)、模型工具鏈(做數據標注、向量數據庫、分布式訓練等)。

「這類公司通常干的是苦活累活」,與此同時,由于業務壁壘淺(不是完成技術的從 0 到 1,而是完成 1 到 100),「中間層」最易受到上下游(大模型和應用)的擠壓——比如誕生于 2022 年 10 月的 LangChain,你可以將其理解為程序員的工具庫,因其能夠幫助普通人(企業)構建大模型應用,為他們提供過程中所需的工具組件和任務集(LangChain 封裝了大量 LLM 應用開發邏輯和工具),因而迅速崛起。但最近半年來,眼看著大模型的能力一再進化,并開放了插件,LangChain 的價值也受到沖擊。

但極客公園在走訪美國硅谷調研后發現,與年初投資人們的消極判斷不同,鑒于巨頭們都在入場中心化大模型,這為中間層提供了巨大的機遇,在海外,中間層正在蓬勃發展。

正如云計算時代,Snowflake(基于底層云計算構建了它的數據庫 PaaS 平臺) 和 AWS 相互成就一樣。大模型時代,中間層和底層算力平臺(及基礎大模型)也正在相互成就。這是因為算力平臺的最終消費者是應用程序公司,而中間層的公司正在幫助做應用的公司快速部署大模型,這進一步增加了底層云計算資源的消耗。

換句話說,中間層的繁榮,直接決定了底層云計算的「管道」能開多大,同時也是上層應用生態得以百花齊放的條件。在硅谷,中間層的一批公司正站在各自不同生態位上,把應用層「抬」進大模型時代,在這過程中,中間層自身也捕獲了更大的價值。

他們是怎么做的?

Databricks 的信仰之躍:13 億美元收購 Mosaic,數據平臺搖身變為AI平臺

原本,數據領域的格局一經確立、就難以松動:尤其是來自集中度高的行業客戶,極其注重其數據的安全性與私密性,以維持自身的競爭壁壘。在海外,除了三大云廠商,Snowflake 和 Databricks 在數據領域做得最好。這樣的格局恒久穩定,除非一次革命性的技術躍遷,否則,數據領域的客戶很難遷移——大模型時代帶來了這次機會。

Databricks 抓住了這次機會。

成立于 2016 年的 Databricks 本是一個數據 + 人工智能的開發平臺,因其早期數據湖的主張和布局(數據湖對 AI 能力要求更高),積累了一定 AI 能力。生成式 AI 爆火后,Databricks 通過一系列行動,迅速補上了大模型相關能力,這些行動包括:收購 Okera(數據治理平臺)、發布 Dolly 系列開源模型、以及最重要的,以 13 億美金收購開源大模型企業平臺 MosaicML。

13 美金的收購象征了 Databricks 的決心。這家公司比對手們更早意識到,在集中度強的行業,企業一定傾向于部署一個私有的大模型。

現在的 Databricks 不僅僅是一個數據倉庫,一個數據湖,還提供 AI 訓練、模型管理等一整套服務。日前,他們發布了自然語言驅動的數據訪問工具——LakehouseIQ,宣布提供開源 LLM 庫——Databricks Marketplace,以及 AutoML(一種自動化機器學習技術)能力——Lakehouse AI。

這些工具與服務意味著,企業或個人能夠更輕松地接入公司數據,用自然語言就能進行數據分析。

過去一個月,不少行業人士認為,接下來,數據或許是軟件公司利用大模型做出差異化最重要的因素——前提是算力成本的降低、開源模型的進步,以及模型部署服務的滲透。也因此,數據領域上下游的中間層公司,如 Databricks,將占據更重要的位置。

近日,Databricks 公布了一個數字:過去 30 天,在其平臺上訓練 Transformer 模型的客戶超過 1500 家。這驗證了在當下,中間層公司所面對的蓬勃需求。

據極客公園了解,Databricks 的毛利率高達百分之六七十——一位大模型創業者指出,Databricks 通過購買多家云廠商(微軟、AWS 等)的算力,并疊加自身的 AI 訓練、模型管理、數據管理等服務,以更高的價格打包出售,是其高利潤的原因,「本質上是賺算力的錢。」

而 Databricks 聯合創始人辛湜告訴極客公園,幫助客戶部署 AI 或者大模型的有很多,但數據平臺有天然的優勢——「數據在這里」,AI 平臺首先要是一個數據平臺,才可以長久。

Scale AI:千金難買精標數據,效率為王

簡單來說,收集、策劃和清洗數據集是模型生產中最大的挑戰。

大模型創業潮中,大多數企業在模型生產中花時間最多、花金錢最多、花精力最多,遇到困難最多的,是整理數據,做數據的特征工程、特征轉化。

(圖注:據 AI Infrastructure Alliance 在 2022 年的年度調查顯示,收集、策劃和清洗數據集是模型生產中最大的挑戰。)

如今數據領域風頭最盛的 Scale AI 創立于 2016 年,最初主要為無人車提供數據標注服務,后來逐漸積累了包括電商、短視頻甚至政府機構的客戶。過程中,它積累了 1000 人的科技管理團隊,幾十萬來自全球的長期外包人員和嚴格的驗收體系。這些積累使得它在大模型時代快速轉身,為企業提供 RLHF 的微調業務。目前,硅谷頂尖的 AI 公司,包括 OpenAI,Cohere,Inflection AI 都是它的客戶。

2016 年,19 歲的華裔創始人 Alexandr Wang 已經有了兩年工程師經驗。在硅谷的當紅公司、美國知乎 Quora,他看到了硅谷科技大公司在和遠程的外包人員合作上的效率痛點,于是,大一的他從 MIT 輟學創立了 Scale AI。

傳統大廠做數據標注時,欠缺的并不是技術,而更多的是對外包人員的即時反饋和管理。在數據量龐大的情況下,外包人員的數量會非常龐大,許多大廠會再找埃森哲這樣的公司去替它們管理外包人員。這在無形之中使得外包人員、提供數據標注軟件的工程師、以及真正需要數據訓練模型的算法工程師——三者之間的溝通不暢。企業支付的價格很高,但數據標注質量卻并不高。

Scale AI 的專長是利用超規格的工程團隊和高素質的外包管理人員,解決數據標注的效率和成本問題。他們在全球招募外包人員進行數據標注,同時將總部設在硅谷,雇傭高質量的硅谷工程師根據企業任務快速構建新的數據標注平臺,再根據外包人員的反饋及時對平臺的功能做出調整。并通過全球化的招募系統,將價格降到最低——相比于美國大廠為了保證反饋需要在國內招人標注,Scale AI 可以根據任務難度,將簡單的任務分發給發展中國家的數據標注員,同時只需支付當地的最低工資。

這又是一家快速轉身抓住機會的公司。據極客公園了解,Scale AI 最初在 RLHF 方面并沒有太深的積累,但是通過過去數據標注方面的積累和極強的工程能力,公司迅速開發出了適合 RLHF 標注的軟件。

借大模型的東風,Scale AI 預計今年業務將增長一倍,據悉毛利在 60% 左右。今年初,首席執行官 Alexandr Wang 在推特上表示,他預測 AI 實驗室很快就會在人類標注數據上花費與底層算力同等量級的數十億美元。

承接硅谷模型水平最高的客戶和擁有最高數據標注吞吐量,利用這些優勢,Scale AI 進一步提供了 Evaluation 和 api 服務。前者可以為訓練模型的企業提供人工測試、給出客觀的建議;后者則可以讓企業自行接入模型,對模型進行特定業務能力的測試。

自成立以來,這家提供數據標注服務的公司已經經歷了兩次大方向的調整,但只要數據時代不斷發展,永遠會有新的長尾數據需要數據標注。這決定了這樣的公司將被持續需要。

Hugging Face 崛起:開源、GPT4 的對手和百花齊放的企業模型

無論是期待拉平 OpenAI 的大模型能力,還是企業想擁有基于自己的數據精調大模型,開源,都被寄予厚望——這導致了 Hugging Face 的崛起。

Hugging Face 是一個專門針對機器學習的開源平臺和社區,在當下則被視為大模型領域的 Github。截止極客公園發稿前,Hugging Face 上擁有超過 27 萬的模型,超過四萬八千個數據集。而僅僅一個多月前,這個數據還是 21 萬多個訓練模型和三萬八千個數據集。增長速度十分驚人,其流行程度可見一斑。

成立之初,Hugging Face 只是一個做聊天機器人的創業公司,因為公司業務需要,一直關注 NLP 技術。Transformer 架構剛剛出現時,研究者想要接入大模型的成本很高,因為一次重寫方案的分享(Hugging Face 分享了自己將基于 tensorflow 實現的 BERT 模型用 pytorch 進行了重寫的方案),Hugging Face 受到了極大的關注。此后,在 Github 中由 Hugging Face 創建的 Transformers 庫里,不斷有其他研究者在其中添加自己的開源模型。很快,Transformers 庫很快成為 GitHub 增長最快的項目,Hugging Face 也轉身開始創建自己的開源平臺。

Hugging Face 的中國區負責人王鐵震告訴極客公園,在技術上,Hugging Face 針對 AI 的特點做了許多優化,比 GitHub 更適合 AI。例如 :

- Hugging Face 支持大文件的上傳。

- 免費提供 hosting,免費提供全球 CDN 的 deliver。

- 開發者在 Hugging Face 平臺可以做版本控制以及開源協作,可使用交互式的方式直接展示模型效果,還可以一鍵部署,快速將模型部署到亞馬遜云上使用起來。

文化上,Hugging Face 也做了許多細致的、ROI 并不高的工作,來培養開源社區的氛圍。比如對第一次來貢獻代碼的開發者進行非常細致的輔導。

從早期主要思考如何幫助研究者快速部署模型,Hugging Face 逐步向工業界發展,開始嘗試提供更多的工具,讓企業能夠更快速地用上一個學術界發布的新模型。

現在,通過 Hugging Face,企業不但可以直接通過 API 接入大模型的能力,也可以通過上傳自己的數據,由 Hugging Face 在多種不同的模型和訓練方法上,找到最適合企業的那一個,直接訓練一個屬于企業自己的大模型。

Hugging Face 沒有特別披露過它的營收狀態,但據福布斯披露,在 2022 年,Hugging Face 已接近盈虧平衡,擁有了英特爾、 eBay、輝瑞、彭博社等超過一千家客戶,2023 年乘上大模型浪潮,客戶只會更多。最新報道稱,Hugging Face 的估值可達 40 億美金。

除了為大公司提供高附加值的定制服務,如果開源大模型繼續發展,成為行業的主流,那么擁有幾十萬個開源大模型的 Hugging Face,也完全有能力為中小開發者提供標準化的產品。

Moveworks:用 Copilot 再造「受大模型沖擊最大的」RPA 賽道

RPA(Robotic process automation),即機器人流程化自動化,意為借由機器人和 AI,無需使用人員具備任何代碼知識,通過拖拉拽,即可快速構建一個「可自動化執行的流程」。

事實上,RPA 是無代碼的一種,顧名思義,這意味不需要寫代碼就可以運行程序,約等于用自然語言進行軟件交互,這正是大語言模型最擅長的事情。因此,RPA 也被視為最容易被大模型顛覆的賽道。

過去,Moveworks 這一公司深耕于 RPA 賽道。2016 年,Moveworks 創始人意識到,AI聊天機器人的潛力,可以在沒有人工參與的情況下,解決很大一部分員工的支持問題。聊天機器人背后的模型可以為員工提供自助服務,以解決常見請求。

最初,Moveworks 解決了員工的 IT 支持問題。2021 年 3 月后,Moveworks 擴展了其員工服務平臺,以解決涉及其他業務線的問題,包括人力資源、財務和其他設施。Moveworks 還發布了一個內部通信解決方案,允許公司領導向員工發送交互式信息。

員工與 Moveworks 聊天機器人交談,提交他們的請求,Moveworks 對其進行分析,然后通過與其他軟件應用程序的集成來解決這些請求,包括:打通企業級系統的 API 和本地服務部署的系統(agent),和打通知識庫系統。

在大模型到來后,這家公司也完成了快速升級,從企業內的聊天機器人發展為幫助企業客戶做 copilot,通過對話來連接人和軟件系統。「在未來,公司的人力資源部可能變成模型資源部。」一位接近 Moveworks 的人士表示。這也為大模型時代的公司管理及雇傭、協作方式提出了新的想象。

Sambanova 的狂想:軟硬件全棧體系,挑戰英偉達!

硅谷的投資人覺得它的產品不錯,而創業者們覺得它是瘋子——成立于 2021 年的 Sambanova 充滿爭議。

原因在于,一家 500 人的公司既在做芯片、也在做模型,同時還要將模型部署到企業。號稱要提供全棧服務的 Sambanova 目前已經募集了 6 輪共計 11 億美元融資,估值 51 億。最近一輪 6 融資為 6.76 億美元,于 2021 年 4 月由軟銀愿景基金 2 領投,淡馬錫和新加坡政府投資公司跟投。投資方還有英特爾資本、 GV (前谷歌風投)、貝萊德基金等。

這家公司認為,伴隨著人工智能崛起,需要與之匹配的新型計算系統。CPU 和 GPU 這樣傳統的馮·諾伊曼架構處理器傾向于指令流(flow of instructions),而非數據流(flow of data)。在這樣的架構中,人們難以控制緩存數據的位置,也就幾乎難以控制數據如何在系統中移動。

為此,Sambanova 以軟件的視角重新定義硬件。「像 GPT-3 這樣的大模型,需要串聯上千塊 GPU 進行訓練、運行。」CEO Rodrigo Liang 說過,這帶來了企業使用大模型的門檻。這家公司的愿景是消除這種門檻——通過提供包括硬件設計、軟件構建、模型預訓練和部署在內的服務,減少企業使用 AI 模型的復雜度和人力投入。

公司的三位聯合創始人皆擁有出色的學術背景:其中兩位為斯坦福大學教授——Kunle Olukotun 是多核處理器設計的先驅,另一位為機器學習教授 Christopher Ré。CEO Rodrigo Liang 此前為甲骨文公司的工程主管——這為其大膽愿景提供了幾分說服力,畢竟,Sambanova 號稱將英偉達視為對手。

Sambanova 稱,在其全棧系統設備 SambaNova Suite 上部署企業模型的成本,與 Nividia+Azure 云服務的方案相比,僅是其 30 分之一。公司的目標客戶是希望結合內部數據,定制千億級別規模參數以上的中大型企業和政府組織。目前,咨詢公司埃森哲已宣布成為其客戶,而更早之前,美國能源部的阿貢國家實驗室 (ArgonneNationalLabs) 也是其早期客戶,購買了其 DataScale 系統。

應用層的窘境:熱度最高,但還未真正「起跑」

一場技術變革能夠真正抵達大眾,最終靠的是百花齊放的應用。

在當下,大模型應用被寄予厚望。無論在海外還是國內,相較于基礎設施層、大模型層與中間層,應用層的創業熱度是更高的——因為后者的技術門檻沒有那么高,又直接面向用戶、容易拿到結果,對于創業者來說更容易上手。

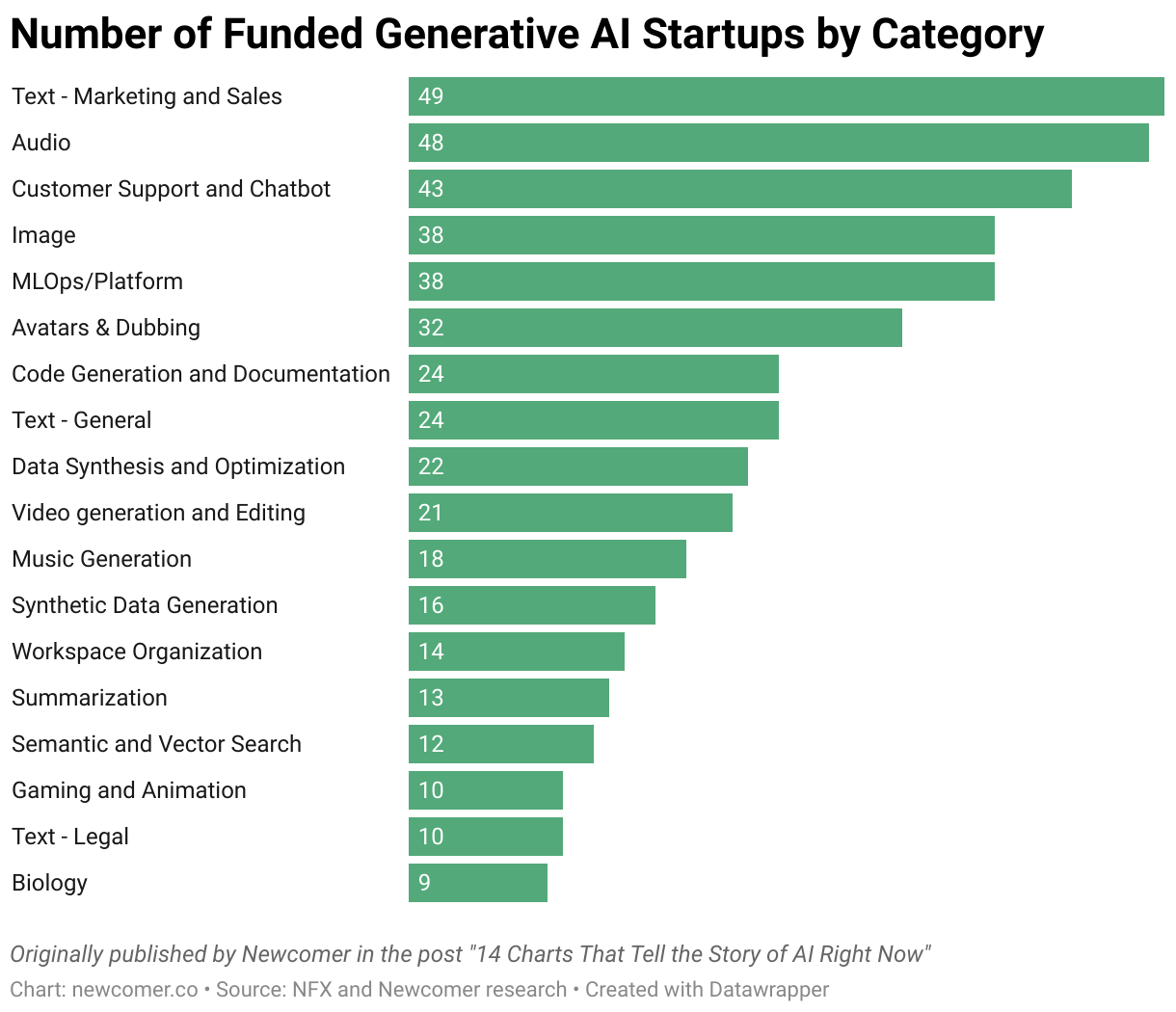

左圖為獲得融資的生成式 AI 初創公司數量排名,排名前四的都是應用層,應用層公司占比在 80% 左右。右圖為生成式 AI 初創公司的融資金額排名,應用層的融資總額也高于中間層。來源:Newcomer

但,大模型應用層的創業真的迎來了 iPhone 時刻嗎?(注:2007 年,iPhone 發布揭開了智能手機的時代,2010 年,iPhone4 的發布和普及掀起了移動互聯網應用的浪潮。)

實際上,當下大模型應用的創新正面臨窘境。

應用層的崛起需要倚賴穩定的底座,以及豐富的中間層工具。但綠洲資本創始合伙人張津劍指出,相較于海外的很多 AI 應用發展更早(如 AI 視頻獨角獸 Runway 成立于 2018 年、文案生成獨角獸 Jasper 創立于 2021 年),中國大模型和應用層的發展幾乎是同步展開的——從今年年初開始,這意味著,應用層發展所倚賴的條件仍不成熟。

按照跟大模型接入的深度,應用層創業可以分為兩類:直接調用已有大模型(閉源模型 API 接口、開源模型)的應用、以及自建模型的應用。

百川智能創始人、CEO 王小川告訴極客公園,自研大模型的每次訓練成本跟訓練 token 數和參數量相關,在中國,每 1 億參數對應訓練成本 1.5 到 3 萬人民幣,一個千億級參數的模型訓練單次訓練成本預估在三千萬至五千萬人民幣。如果對于模型的能力有更高要求,比如追上 GPT4.0 的水平,單次訓練投入超過 5 億人民幣。這樣的成本門檻就已將許多人攔在門外。但是,通常在訓練之前還需要做大量的實驗來確定訓練所會采用的策略,外加人力及數據上的投入,一個效果好的模型的整體投入會是單次訓練投入的 5-10 倍。

如果在可商用的開源模型(如 Llama)上改,亦或是接入已有大模型,效率和效果也都未必令人滿意。且鑒于國內大模型的能力較海外尚有差距,「大部分應用層創業使用的是海外模型,產品直接落地在海外市場。」應用層創業者王安屹告訴我們。

技術如果天天跳躍,只做一層「薄」的應用是很容易被顛覆的——多名投資人表達了這樣的看法。大模型的迭代速度極快,底層的技術飛躍將很大程度限制應用的發展。一個典型的例子是,在 GPT-4 發布后,輔助寫作的獨角獸 Grammarly 和 Jasper 的價值迅速被攤薄了。金沙江創投主管合伙人朱嘯虎曾認為,「這兩家公司或將很快歸零,根本守不住。」

實際上,今天在中國要做一個基于大模型的超級應用,甚至能產生商業正循環的應用,對創業者的能力挑戰非常大。類似百川智能創始人王小川、出門問問李志飛等極少數人,目前能同時具備「自有模型技術建立——行業調優——應用生產」的全棧能力,有機會脫離國內基礎大模型的發展進度,開始構建直通應用的完整競爭力。而大部分在場景、交互、產品定義能力上有特點和優勢的創業者,因為國內大模型本身的技術不成熟、產業鏈不健全,基本很難進行「端到端」的探索實踐。

「恐懼和憂慮肯定是有的。」360 集團副總裁梁志輝告訴極客公園,一旦大模型的能力迭代至另一境界,的確可能顛覆團隊半年來的所有努力,「但真正的玩家必須在這時下場,不管能不能贏,否則你連上牌桌的機會都沒有。」梁志輝說。

極客公園創始人張鵬也提及發起這次 AGI Playground 大會的初衷:「join and play to earn the lead time(加入并參與,去贏得領先時間)」——在他看來,AGI 的技術變革必然蘊含巨大機遇,但當下,大模型帶來的創業機會距離真正爆發還有一定時間,這時候無論創業者還是投資人,提前「下場」未必一擊中,但「參與」、「實踐」都是在為自己、或團隊贏得「Lead time」,以便能在真正起跑時「Be ready」。

「中美創業者的勇氣和心態有一定不同。」真格基金合伙人劉元提到。極客公園調研硅谷后也驗證了這一點,相較于中國創業者,美國的年輕團隊更敢想、敢干——在硅谷,我們接觸到了一系列尚且「粗糙」的項目靈感:比如用 AI 做訓犬的 copilot、亦或是人類的社交助手。這或許和硅谷的創業文化相關,人們花更多時間思考差異化的價值,也更包容探索中的失敗。

盡管當下應用層創業受到諸多限制,但客觀上仍存在機會:比如,雖然模型本身已經具備了很多能力,但在一些需要更專業的數據體系支撐、對服務要求更高的場景中,模型的服務能力依然有限。

創業者王安屹指出,在 2G(政府)、2B(企業)等場景,這些領域的數據獲取難度高,更容易形成壁壘。在國外,有專門做法律場景的 Harvey.ai 等公司。國內,也有創業公司主攻零售、醫療、營銷等垂直場景——需要注意的是,在國內,數據化是當下的首要挑戰,「企業普遍存在數據散落在各地、且難以被提取等問題,因此(產品)建立數據飛輪,可能要從幫助企業能更容易地收集數據開始。」

此外,數據飛輪也能幫助應用產品形成壁壘、避開模型的能力邊界。對此,投資人 Kyle 指出,隨著大模型的每一次迭代,都有應用層的產品被唱衰。但隨著時間推移,部分產品的表現依然很頑強,收入、用戶等數據并沒有如預期下降。

再以文案生成器 Jasper.AI 為例,盡管一再被「唱衰」,但用戶反饋顯示,Jasper 的文案生成表現依然處于市場領先地位。創立兩年,Jasper 已經積累了一定的用戶數據,「這也是產品價值力的體現。」Kyle 認為,這來自創始人較強的工程能力(更好地調用大模型)、對業務場景(B 端文案)的深刻理解、以及時間上的先發優勢。

對于創業者而言,找到場景、拿到需求至關重要——「悲觀者往往正確,而樂觀者往往成功」,張津劍說,「最終能勝出的應用層項目,一定是抓住一個確定的用戶需求,通過不斷的用戶反饋和數據積累,進一步迭代產品,從而形成壁壘、避開模型的能力邊界。」

中國大模型生態推演:巨頭是重要玩家,但不止是巨頭的游戲

在 ChatGPT 爆火后,國內玩家們歷經半年的狂熱,已逐步冷靜下來。據極客公園觀察,與年初相比,國內的創業者、巨頭公司,其中不少人已放棄大模型軍備競賽之路,而轉向更務實的思考——大模型最終如何落地?有怎樣的應用價值?如何探索商業化?

經過 7 月初在上海的 WAIC(世界人工智能大會),三十多家大模型「百模齊放」,擁有大模型本身已經不再令人驚奇。從功能上而言,擁有文生文、文生圖、代碼 Copilot 能力的模型也不在少數。

但整體看來,中美大模型的商業生態呈現出不同的氣候。

- 從模型能力上而言,中國模型的能力大多處于初步可用、但不及 GPT3.5 的水平,開源可商用的模型亦相對缺乏,這也一定程度上影響了工具層和應用層創業;

- 從商業生態而言,美國已經初步顯現模型層、中間工具層、應用層的不同生態位。中間工具是圍繞定制、部署、使用而出現的一系列工具,例如模型托管平臺如 Hugging Face,模型實驗管理工具平臺 Weights&Biases,像 DataBricks、Snowflake 這樣的數據庫也在原有平臺上疊加模型相關的能力與產品,目的是讓企業級用戶在平臺上一站式使用數據定制化模型。而在中國,大模型創業公司之外,獨立的工具層生態尚未成氣候,目前提供相關功能的主要是以大廠為代表的云平臺,外加零星的創業公司。

- 而在產業探索進程上,中國 C 端應用尚未大規模放開,如百度、金山尚處于邀請碼內測階段,知乎曾發布基于大模型的新功能,也處于內測階段,行業仍在等待合規。B 端服務則處于混沌狀態,一些行動較快的模型創業公司嘗試為企業做定制化模型,處于積累案例經驗的階段,而企業需求與技術提供方之間存在溝通隔閡,則是更普遍存在的情況,更重要的是,中國行業的信息化數字化程度整體較為落后,這顯然會影響速度,但長遠來看,留給模型廠商的空間更大。

基于這些不同情況,現階段中國創業者在大模型領域,所要解決的主要任務亦不同。

在中國,任何涉及 toC 的大模型服務,合規先行是必然趨勢,合規模型將會率先在市場上提供服務,并在大規模 to C 的應用場景上獲得先機;模型質量上,媲美 GPT3.5 的優質基礎模型依舊是訓練目標。而在訓練過程中,由于算力整體有限,高效集中資源并使用,將更加重要。除了需要考慮算力的集中和分配,減少不必要算力消耗的訓練技巧也將是重要的經驗。

極客公園了解到,有消息表示,隨著監管明確,第一批合規模型放出是值得期待的。同時目前在 toB 領域的應用上,實際上已沒有官方的合規要求,這將助推大模型落地企業,也將推動工具層和應用層發展。

目前,模型公司紛紛宣布開源模型可商用,極客公園了解到,在參數規模上,國內的開源可商用模型將穩定在 13B (130 億)左右的規模。趨勢上,國內少數有能力的創業公司將繼續訓練更大規模的模型,并選擇閉源;而也會有很大一部分企業,則會根據需求訓練模型,不以規模為絕對的追求,而是滿足業務探索需求。比如騰訊內部自研了一批從十億到千億規模的模型,金山為了更好地響應辦公文檔「WPS AI」的用戶需求,內部也訓練了小模型,作為接入的基礎模型能力補充。

另外,隨著應用及場景拓展,模型輸出能力的方式將變得更受關注。按照模型能力輸出的方式,具體可以分為中心化和非中心化兩種方式。

中心化模式即企業調用通用大模型、或第三方行業垂直模型的 API 去構建業務功能;非中心化模式則是指,企業根據使用場景和功能,用專有數據微調(Finetune)擁有一個甚至多個模型。這樣的專用模型甚至不必追求規模,可以相互協作解決問題。業界普遍認為,只需要在百億參數規模上進行特定領域的知識增強,便能夠在特定功能上達到比通用模型更加有效的效果。

極客公園在調研后認為,在中國(美國也類似),第二種非中心化模式的市場占比將會更高。按照百川智能的創始人王小川的觀點,「80% 的價值可能是蘊含在非中心化的模型和服務里的」。實際上,像電商、社交、游戲等存在巨頭、集中化程度高的垂直領域,巨頭絕不會使用他人的模型來構建業務。

背后的邏輯在于,在這些領域內,數據是關鍵性資產,通用模型不具備服務某一領域的能力,接入數據后才具有專業能力,但所謂的行業模型一旦模型能力全行業共享后,意味著一定程度上競爭壁壘的消弭,因此必然會形成各家在數據墻內訓練專用模型的形態。未來,隨著模型支持業務的場景和功能變得豐富,模型群落將逐漸形成。

金山辦公是目前的典型案例,在測試階段,金山辦公已接入了 MiniMax、智譜、百度三家不同的基礎模型對外提供服務,同時在一些簡單的推理任務上,直接使用自研的小模型。

而在集中度不高的商業領域,或者非完全市場化的一些關鍵行業,或許會出現一個領域模型以 API 服務多家的形式。華為發布盤古大模型時,同時發布在政務,金融,制造,礦山,氣象等垂直領域發布模型,便是這種布局思路。

此外,在中國未來的大模型體系里,巨頭仍然會是大模型商業世界的核心玩家。

中國尚沒有出現 DataBricks、Hugging Face 這樣的模型工具平臺,取而代之的是各大云廠商推出的服務與平臺。雖然對外宣傳的側重各有不同,但形式基本一致,以云平臺搭載多個模型提供服務,其中包括第三方模型+自研模型。騰訊甚至在發布模型平臺之外,發布了作為中間層工具的向量數據庫產品。

最鮮明的是火山引擎,以 Maas 的形式在云上集結了多家大模型對外輸出服務。同時火山引擎提出,未來企業使用大模型會呈現「1+N」的模式。而火山引擎推出的「模型商店」,目的就是方便企業挑選合適的模型進行組合。百度最早發布文心一言大模型,現在也已在百度上線第三方模型。火山引擎、騰訊雖然沒有官宣,但趨勢已經形成:自研模型將會和第三方模型一起在云平臺上提供服務。

在今天,巨頭比任何公司都更警惕范式革命的降臨。因為理論上,巨頭隨時可能被對手發起閃擊戰——一旦大模型能力注入產品提供顛覆性的價值,對于原有業務可能是巨大的沖擊。而經歷移動互聯網時代多年的積累,上一代互聯網平臺已經呈現出生態位的復雜性。以阿里、騰訊、字節、百度為代表,它們既擁有現成的 to C 場景以及規模優勢,提供云平臺服務的同時也自研模型。當自研模型能力注入原有場景后,toC 領域的邊界會重新模糊。由此也不難理解,為何巨頭無法承受錯過大模型的代價。

復雜性亦體現在巨頭和生態的復雜競合關系中。

在國內,巨頭們紛紛聚焦云業務與「模型商店」的模式:既以云業務「服務」其他第三方模型創業公司,同時也有自研模型、有可能會與創業公司的模型競爭——這將帶來的復雜問題是,無論是從技術上還是業務上,彼此的邊界如何明確。

以字節旗下的火山引擎為例,大模型領域的創業者如果用火山訓練和部署了精調模型,歸屬權是否必須屬于火山云?而未來的創業公司,如果在火山云上為客戶提供 MaaS 服務,由此所帶來的用戶數據,與這家創業公司是否必須隔離開(即創業公司無法接觸到所服務的客戶的數據)?這些都是火山引擎曾經與創業者們的分歧所在。

精調模型的歸屬問題背后,也指向云平臺的擔心:創業者使用了云平臺的算力之后,直接打包走模型能力和所服務的客戶,于是云平臺僅僅扮演了「一次性服務」的角色,并未成為真正的 Maas 平臺。

而數據隔離背后的邏輯更為復雜。。首先,確實有安全性問題,模型公司進入,破壞了云平臺原有數據安全體系,需要有所隔離。其次,模型公司如果不斷接觸用戶數據,極可能以客戶數據不斷增強自己的模型能力,這將形成模型公司與 MaaS 平臺關系的不平衡,會讓平臺角色退向算力供應商,而非在生態中更上的站位。這種非本地部署的 MaaS 方式,也會帶來行業核心客戶的競爭力流失,進而破壞云平臺的存在根基。

盡管被動,但目前,創業者又很難離開火山這樣的云平臺。不僅因為通過火山能夠找到模型的潛在客戶,更因為火山擁有算力,且提供的服務「很便宜」,「只有這里能訓」。

另外在 MaaS 模式下,巨頭麾下的云平臺本身與其他提供模型的第三方企業是合作與上下游關系,但巨頭自研的模型,與第三方模型同樣作為選項進入自家的「模型商店」,又會帶來一定的競爭關系。長遠看來,這樣的競合也會成為影響生態的關鍵因素。

好在可以確定的是,豐富的生態中,絕不只有大模型這一個競爭點。在國內,巨頭一定是最重要的玩家,但大模型絕不止是巨頭的游戲。

不少人認為,巨頭無法對抗組織重力,「可能還不如小創業公司聚焦。」且在當下宏觀環境中,國內巨頭并不推崇無限擴張,這為生態上下游的創業公司都留足了機會與空間。在此背景下,業內人士認為,「大廠的戰略投資部將重新變得重要,因為來自技術的狙擊將隨時發生,戰投的使命是為公司探索未來。」

長期而言,圍繞模型形成的生態和商業模式將成為競爭壁壘。據極客公園觀察,國內的大模型創業公司已經在圍繞模型培育生態,方式包括完善面向開發者的工具和技術模塊,開源版本及社區運營等。

一個企業用戶,是直接尋求模型企業的服務,還是選擇云平臺方案,會受諸多因素影響,比如成本、方案便捷性、行業競合關系、對模型自主的需求、自身技術實力等。而互聯網巨頭目前的業務格局,既會帶來快速滲透場景的優勢,又可能會因本身業務多重性帶來的競合關系,存在一定牽制。

「百模大戰」在中國很可能不會持續太久,有關大模型本身的競賽也將很快不再是產業的焦點,誰能率先提升中國大模型的能力到 GPT-3.5 甚至 4.0 的水平、誰能在未來非中心化模型崛起的時代,「多快好省」地幫企業落地大模型構建現實競爭力、誰能率先把大模型能力落到細分場景和產業形成顛覆性創新,將是下一個階段的核心看點。